Was bedeutet das DRITTE REICH?

Das Dritte Reich oder Nazi-Deutschland, Es ist eines der bekanntesten Reiche in der Geschichte der Menschheit, vor allem aufgrund der enormen Verbrechen gegen die Menschlichkeit, die es in den Jahren seines Bestehens verursacht hat. Doch viele Menschen wissen nicht, was das Wort bedeutet Reich, ein sehr wichtiger Begriff in der deutschen Geschichte, den wir aber meist nur auf die NS-Zeit beziehen. Um über all dies in der Tiefe zu sprechen, müssen wir in dieser Ein-Lehrer-Lektion über was sprechen Was bedeutet Drittes Reich?.

Index

- Was war das Dritte Reich?

- Das Erste Reich und das Zweite Reich Deutschlands

- Kurze Zusammenfassung des Dritten Reiches

Was war das Dritte Reich?

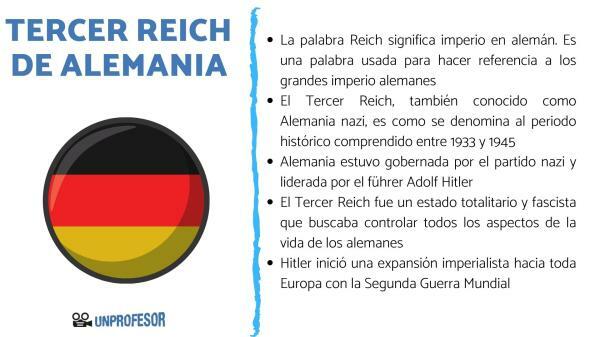

Das Dritte Reich, auch bekannt als Nazi Deutschland oder in seltenen Fällen das nationalsozialistische Deutschland, ist das, was die historische Periode umfasst zwischen 1933 und 1945, als Deutschland von der NSDAP regiert und vom Führer geführt wurde Adolf Hitler.

Daher können wir definieren Drittes Reich als totalitärer und faschistischer Staat die versuchte, alle Aspekte des deutschen Lebens zu kontrollieren, indem sie zahlreiche Repressionen durch die Polizei und die Armee durchführte, um jedermanns Freiheit abzuschneiden.

Hitler betrachtete sein Deutschland als ein sich entwickelndes Imperium, also war seine Idee von Anfang an die imperialistische Expansion in ganz Europa, versuchen, so viel Territorium wie möglich zu beherrschen, um Deutschland wieder zu einem großen Imperium zu machen und Europa zu kontrollieren und zu beherrschen.

Das Erste Reich und das Zweite Reich Deutschlands.

Um die Gründe zu verstehen, die Hitler dazu veranlassten, seine Regierung als Drittes Reich zu bezeichnen, müssen wir darüber sprechen, wass Reich, das existierte und über das Wort selbst, um die historische Bedeutung zu verstehen, die dieser Begriff für die Deutschen hatte.

Das müssen wir erst einmal verstehen das Wort Reich es bedeutet Reich auf Deutsch, Es handelte sich also um ein Wort, das verwendet wurde, um sich auf das große deutsche Reich zu beziehen, obwohl es anders verwendet wurde. verallgemeinerte Art, den deutschen Staat zwischen den Jahren 1871 und 1871 offiziell als Deutsches Reich zu bezeichnen 1945. So können wir sagen, dass das Wort Reich wurde in der Geschichtsschreibung verwendet, um sich auf die zu beziehen Kaiserzeit der Deutschen und im Fall des Dritten Reiches sich selbst die Bedeutung zu geben, sich selbst als großes Imperium zu betrachten.

Nachdem wir kommentiert haben, was die Reiche sind, müssen wir über die ersten beiden sprechen, um das enorme zu verstehen Bedeutung, die dieses Wort für die Deutschen hatte, und die Gründe, warum die Nazis sich so nennen wollten.

Erstes Reich

Der Begriff Erstes Reich wird verwendet, um die zu benennen Heiliges Germanisches Reich, eines der langlebigsten Imperien der Welt, chronologisch geordnet zwischen 806 und 1806. Es war mehr als ein Staat als solcher, sondern eine Reihe von Reichsstaaten, die von Fürsten geleitet und alle von einem Kaiser geführt wurden, der eine nicht erbliche Position hatte. Sie war eine der Hauptstreitkräfte in Mittel- und Westeuropa, bis Napoleon sie Anfang des 19. Jahrhunderts in zahlreichen Schlachten zur Auflösung zwang.

Zweites Reich

Das Zweites Reich ist der Name, der der deutschen Periode gegeben wird, die umfasst wird zwischen 1871 und 1918, beginnend mit der Vereinigung Deutschlands aufgrund der bedeutenden liberalen revolutionären Bewegungen, die Europa im 19. Jahrhundert verwüsteten und mit der Niederlage im Ersten Weltkrieg endeten. Es war eine der mächtigsten und reichsten Nationen Europas und gilt daher als einer der Pioniere der industriellen Revolutionen.

Kurze Zusammenfassung des Dritten Reiches.

Um mit dieser Lektion über die Bedeutung des Dritten Reiches fortzufahren, müssen wir die Geschichte des Dritten Reiches kurz zusammenfassen, um zu verstehen, worauf wir uns beziehen, wenn wir dieses Wort verwenden.

Nach dem Zweiten Reich trat Deutschland in eine historische Periode ein, die als bekannt ist Weimarer Republik, eine parlamentarische Demokratie. Nach Hitlers Sieg Bei den Wahlen von 1933 wurde das Dritte Reich geboren, das die deutsche Demokratie durch eine ersetzte diktatorischer und totalitärer Staat, das Verschwinden aller Rechte der Deutschen.

Hitler nannte sich Führer, dem Führer des Dritten Reiches, und der alle relevanten politischen Ämter besetzte, so wurde der Diktator zu jemandem, der über dem Gesetz stand und unantastbar war. Die Vorstellung von Hitler ist, dass er eine Art Kaiser des neuen Deutschlands war und deshalb über allem stand.

Die Idee des Dritten Reiches war es, ein großes Imperium zu bilden und deshalb begann die Zweiter Weltkrieg, die Angriffe auf viele europäische Bevölkerungen initiierten und mit Hitler im Hinterkopf, ganz Europa zu kontrollieren. Hitler verteidigte die Idee Deutschland war biologisch überlegen gegenüber den übrigen Völkern und vor allem anderen Rassen wie den Juden oder den Zigeunern überlegen, für die Hitler eine Erweiterung seines Reiches für notwendig hielt.

1945 verloren die Deutschen den Krieg, das sogenannte Dritte Reich beenden und Deutschland langsam zur Demokratie zurückführen. Vorerst das letzte Reich zu sein, das Deutschland hatte.

Wenn Sie weitere ähnliche Artikel lesen möchten Was bedeutet Drittes Reich - Zusammenfassung, empfehlen wir Ihnen, in unsere Kategorie einzutreten Geschichte.

Literaturverzeichnis

- Burleigh, M. (2013). Das Dritte Reich: Eine neue Geschichte. Stier.

- Bolaano, R. (2016). Das Dritte Reich. Alfaguara.

- Moos, G. L. (2005). Die Verstaatlichung der Massen: Politische Symbolik und Massenbewegung in Deutschland von den Napoleonischen Kriegen bis zum Dritten Reich. Martial Pons Geschichte.